Kate Crawford & Trevor Paglen : Training Humans

Suite à cette exposition, polémique autour de la base de données ImageNet.

Kate Crawford & Trevor Paglen : Training Humans

Fondazione Prada, Milan

12 sept. 2019 Р24 f̩vrier 2020

COMMUNIQUÉ

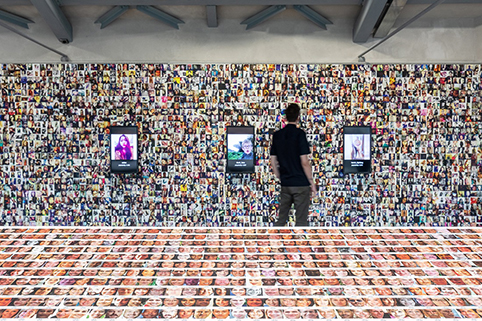

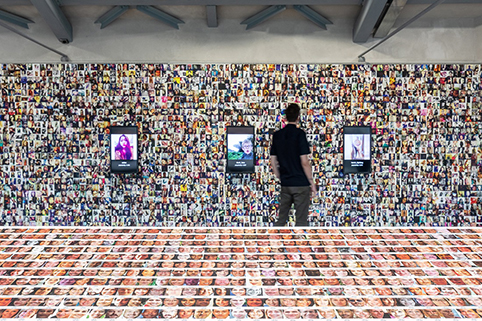

Training Humans, exposition conçue par Kate Crawford (chercheur et professeur en intelligence artificielle) et Trevor Paglen (artiste et chercheur) est la première grande exposition de photographies consacrée aux collections de photos utilisées par les scientifiques pour entraîner les systèmes d’intelligence artificielle (IA) à “Voir“ et catégoriser le monde.

Dans cette exposition, Crawford et Paglen révèlent l’évolution de ces ensembles d’images et de ces pratiques d’IA, des années 1960 à nos jours. Comme le souligne Trevor Paglen, “lorsque nous avons commencé à conceptualiser cette exposition il y a plus de deux ans, nous voulions raconter une histoire sur l’Histoire des images utilisée pour “reconnaître“ les humains dans la vision assistée par ordinateur et les systèmes d’IA. Kate Crawford : “Nous voulions nous intéresser à la matérialité de l’IA et prendre au sérieux ces images de tous les jours comme une partie intégrante d’une culture visuelle machinique en évolution rapide. Cela nous a obligés à ouvrir les boîtes noires et à examiner le fonctionnement actuel de ces “moteurs de vision“ “.

Training Humans explore en particulier deux questions fondamentales : la manière dont les êtres humains sont représentés, interprétés et codifiés lors de ces processus de reconnaissance faciale à travers de grands ensembles de données, et comment les systèmes technologiques exploitent, étiquettent et utilisent ce matériel. Plus les classifications des humains par les systèmes d’IA deviennent invasives et complexes, plus leurs partis pris et leurs politiques deviennent apparents. Dans le cadre de la vision par ordinateur et des systèmes d’IA, les formes de mesure se transforment facilement – mais subrepticement – en jugements moraux.

Les taxonomies classificatoires liées à l’affect et aux émotions de l’homme sont particulièrement importantes pour Crawford et Paglen. Sur base des théories très critiquées du psychologue Paul Ekman, affirmant que le sentiment humain pouvait être réduit à six émotions universelles, les systèmes d’IA mesurent maintenant les expressions faciales des personnes pour effectuer des évaluations allant de la santé mentale à la possibilité d’engager quelqu’un, ou encore à savoir si une personne va commettre un crime.

En examinant les images de cette collection et en examinant comment les photographies personnelles ont été étiquetées, deux questions essentielles se posent : quelles sont les limites entre la science, l’histoire, la politique, les préjugés et l’idéologie dans l’intelligence artificielle ? Et qui a le pouvoir de construire et de tirer profit de ces systèmes ?

Comme l’a souligné Crawford, “ces outils reposent sur une asymétrie de puissance extrême. Ce que nous espérons, c’est que Training Humans nous laisse au moins un moment pour commencer à revenir sur ces systèmes et à comprendre, de manière plus légale, comment ils nous voient et nous catégorisent.“

Fondée en 2009, ImageNet a été créée par des chercheurs de l’Université de Stanford et de Princeton, qui ont extrait des millions de photos de la base de données à partir d’Internet. Les chercheurs ont ensuite recruté cinquante mille travailleurs faiblement rémunérés via la plateforme de travail en libre-service d’Amazon, Amazon Mechanical Turk, pour appliquer des étiquettes aux images. Les préjugés des travailleurs ont finalement été intégrés au projet et, comme le révèle la demande de Paglen et Crawford, les préjugés de ce bassin de main-d’œuvre se reflètent dans les technologies d’IA basées sur les données. Puisque l’IA est utilisée non seulement par les géants de la technologie et les laboratoires universitaires, mais également par les gouvernements des États et fédéraux et les organismes chargés de l’application de la loi, les failles de ses ensembles de données peuvent avoir un impact considérable.

LIENS

Le communiqué de l’exposition à la Fondazione Prada à Milan [EN] :

→ fondazioneprada.org

Le même communiqué (PDF) :

→ fondazioneprada.org

![]()

UNE PURGE DE 600 000 PHOTOS AU SEIN D’UNE BASE DE DONNÉES D’IMAGES SUITE AUX PRÉJUGÉS RÉVÉLÉS PAR LE PROJET DE TREVOR PAGLEN

Titre original : Image Database Purges 600K Photos After Trevor Paglen Project Reveals Biases

Unsigned (News), artforum.com, September 24, 2019.

ImageNet — une base de données de plus de 14 millions d’images et l’une des sources les plus utilisées pour l’apprentissage automatique des systèmes d’intelligence artificielle (IA) et la reconnaissance faciale de personnes et d’objets — a annoncé son intention de supprimer plus de 600 000 photos de personnes de son système. La nouvelle arrive cinq jours après que Kate Crawford (professeure émérite de l’Université de New York et cofondatrice de l’AI Now Institute) et Trevor Paglen (artiste et chercheur) ont dévoilé ImageNet Roulette, un projet viral illustrant les partis pris et la faillibilité de l’identité du programme.

Présentée actuellement dans l’exposition “Training Humans“ de Paglen et Crawford qui s’est ouverte au musée de la Fondazione Prada à Milan la semaine dernière, ImageNet Roulette permet aux utilisateurs de télécharger des selfies pour voir comment l’IA les classerait. Les catégories humaines ont été adaptées des étiquettes réelles d’ImageNet, qui vont des mots “enchanteresse“, “flûtiste“, “bébé prématuré“, “microéconomiste“, “skieur“ et “médiateur“ à des étiquettes plus accablantes, en passant par des insultes racistes et misogynes telles que “salope“, “violeur“, “négroïde“ et “criminel“.

Fondée en 2009, ImageNet a été créée par des chercheurs de l’Université de Stanford et de Princeton, qui ont extrait des millions de photos de la base de données à partir d’Internet. Les chercheurs ont ensuite recruté cinquante mille travailleurs faiblement rémunérés via la plateforme de travail en libre-service d’Amazon, Amazon Mechanical Turk, pour appliquer des étiquettes (labels/tags) aux images. Les préjugés des travailleurs ont finalement été intégrés au projet et, comme le révèle l’approche de Paglen et Crawford, ces partis-pris se reflètent dans les technologies d’IA basées sur les données. Puisque l’IA est utilisée non seulement par les géants de la technologie et les laboratoires universitaires, mais également par les gouvernements des États fédéraux et les organismes chargés de l’application de la loi, les failles au sein de ses ensembles de données peuvent avoir un impact considérable.

“Comme nous l’avons montré, ImageNet contient un certain nombre de catégories problématiques, offensives et bizarres“, écrivent Paglen et Crawford dans leur document de recherche. “Les résultats obtenus par ImageNet Roulette s’appuient souvent sur ces catégories. C’est inhérent à leur conception: nous voulons mettre en lumière ce qui se passe lorsque les systèmes d’IA sont formés à l’aide de données problématiques. Les classifications d’IA des personnes sont rarement rendues visibles aux personnes classées. ImageNet Roulette donne un aperçu de ce processus et montre comment les problèmes peuvent survenir.“

Bien qu’ImageNet n’ait pas invoqué ImageNet Roulette quelques jours après que le projet d’art numérique soit devenu viral, ImageNet a annoncé qu’il supprimerait 438 catégories de personnes et 600 040 images associées qu’ils ont qualifiées de non sûres. “À mesure que les technologies d’IA expérimentées au sein des laboratoires de recherche se rapprochent de la vie quotidienne des gens, veiller à ce que les systèmes d’IA produisent des résultats appropriés et équitables est devenu une question scientifique importante“, indique le communiqué. La base de données prévoit également de mettre à jour son site Web afin que les futurs utilisateurs puissent signaler des termes injurieux.

En réponse, Paglen et Crawford ont annoncé qu’elles mettraient ImageNet Roulette hors ligne le 27 septembre, car ce projet a maintenant “fait valoir son point de vue et a inspiré une conversation publique longtemps attendue sur la politique en matière de données de formation, come un appel à agir pour que la communauté de l’IA affronte les inconvénients potentiels de la classification des personnes. »

LIENS

Image Database Purges 600K Photos After Trevor Paglen Project Reveals Biases

Unsigned (News), artforum.com, September 24, 2019.

→ www.artforum.com

ImageNet Roulette :

→ https://imagenet-roulette.paglen.com/

![]()

AUTRE ARTICLE

Leading online database to remove 600,000 images after art project reveals its racist bias

Artist Trevor Paglen and AI researcher Kate Crawford have investigated the troubling ways in which ImageNet classifies people

Cristina Ruiz, Theartnewspaper.com, 23rd September 2019.

→ www.theartnewspaper.com